接上篇未完的内容,评论的内容是这次我们分析的重点。

import pandas as pdpd_all = pd.read_csv("df_all_new.csv",encoding = "utf8")pd_all = pd_all.drop_duplicates()pd_bad = pd_all.loc[pd_all["msg"]=="留言有非法关键词,请检查后再提交"]pd_all.drop(132).shapepd_all.head()

我们读取上次爬到的csv,删除留言有提示错误的一行,我们主要分析的是msg这一列。

str_data = ''for i in range(pd_all.shape[0]):str_data = str_data + str(pd_all.iloc[i,11])str_data

我们把每一行的内容用循环取出来,并转为str。

import jieba.analysetags = jieba.analyse.extract_tags(str_data, topK=50, withWeight=True)label = []attr = []for item in tags:print(item[0]+' '+str(int(item[1]*1000)))label.append(item[0])attr.append(int(item[1]*1000))words = [list(z) for z in zip(label,attr)]words

用jieba分词,TF-IDF取重点最大的50个词,并把内容和比重保存起来。

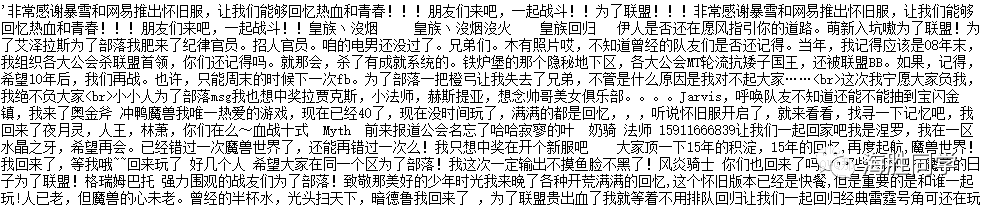

from pyecharts import options as optsfrom pyecharts.charts import Page, WordCloudfrom pyecharts.globals import SymbolTypec = (WordCloud().add("", words, word_size_range=[20, 100]).set_global_opts(title_opts=opts.TitleOpts(title="WordCloud-基本示例")))c.render_notebook()

好啦,最后用pyecharts里面的词云图做一张图吧。

15年 魔兽 怀旧 回归 部落 联盟 一起 为了 同 一个 世界!